您现在的位置是:首页 > 互联网网站首页互联网

IBM研究人员为人工智能培训设计了一种快速节能的芯片

- 互联网

- 2022-02-15 17:26:44

- 来源:

得益于强大的图形芯片和分布式计算的发展,优化人工智能核心的算法比以往任何时候都更容易。但是它在今天的硬件中并不特别有效——即使是强大的图形处理器也需要几天或几周的时间来训练神经网络。

这促使IBM的研究人员开发了一种专门为人工智能培训量身定制的新芯片。在《自然》杂志发表的一篇题为《以模拟记忆的同等精度加速神经网络训练》的论文中,他们描述了一种晶体管和电容系统,可以快速、准确、高效地训练神经网络。

神经网络由被称为神经元或节点(节点集被称为层)的互连单元组成,这些单元接收数字输入。在基本网络中,单个神经元将这些输入乘以一个值-一个权重-并将它们传递给激活函数,激活函数定义了节点的输出。通过一种称为反向传播的策略,权重随时间调整,这提高了输出的准确性。

GPU非常适合这些,因为与按顺序处理数字的传统处理器不同,它们可以并行执行大量计算。但是,由于图形芯片中的处理器和内存在主板上相距很远,因此在它们之间来回切换数据时会引入延迟。

“传统计算机(消耗)大量能源,”领导该项目的IBM博士后研究员Stefano Ambrogio在接受采访时告诉VentureBeat。“还有很多等待。”

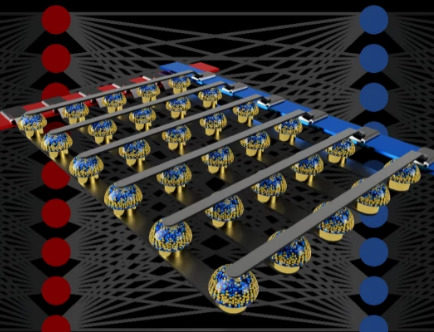

科学家的解决方案包括模拟存储器和传统电子元件。由一对相变存储器(PCM)单元组成的单个单元以及电容器和三个晶体管的组合对应于网络中的每个神经元。PCM重量数据存储在存储器中,表示为晶体管和电容器中的电荷。

当网络经过训练后,电容器将更新其重量,并在数千个周期后将其传输到动力系统控制模块。

电容的值不能超过几毫秒,但可以快速编程。PCM是非易失性存储器,不需要外部电源来存储数据。

研究硬件PCM和软件仿真组件的混合来设计基准是有希望的。这种芯片每平方毫米的计算量比GPU高100倍,但功耗却低280倍。更令人印象深刻的是,它与谷歌TensorFlow机器学习框架在各种计算机视觉任务中的速度和准确性相匹配。

“我们可以以非常精确的方式执行(计算),这与软件的准确性是一样的,”Ambrogio说。

研究人员的芯片设计并非没有重要警告:它没有针对未完全连接的神经网络进行优化,例如用于尖端语音识别应用的长期短期记忆(LSTM)网络。但是研究人员计划下一步解决这个问题。

Ambrogio认为,他们未来可以大规模制造物理芯片。他认为,它们被用于在智能手机和其他目前缺乏必要计算资源的设备中训练神经网络。

“如果能在需要的地方直接处理AI就好了,”安布罗吉奥说。“当你可以训练模型时,你不需要发送信息[到云]或让[设备]与其他事物交流,它可以立即对某件事做出反应。